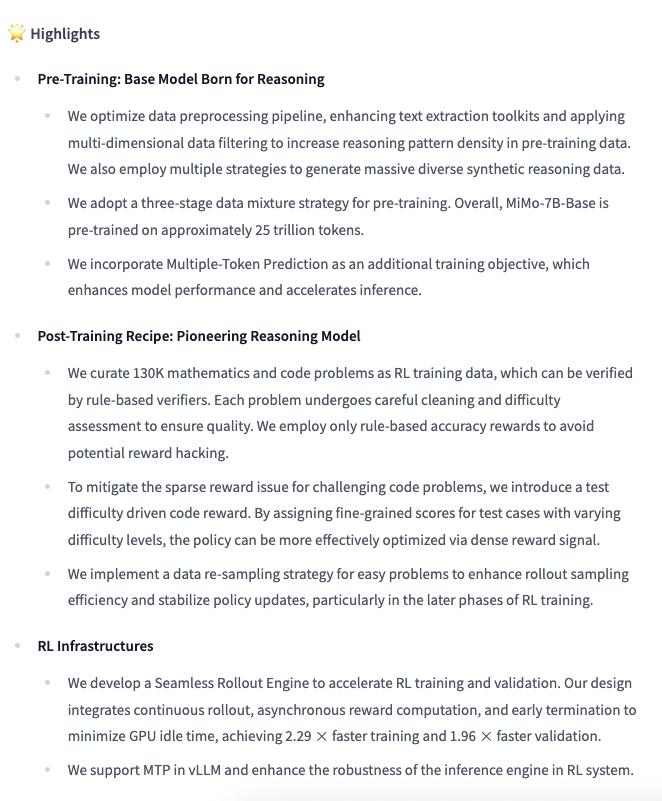

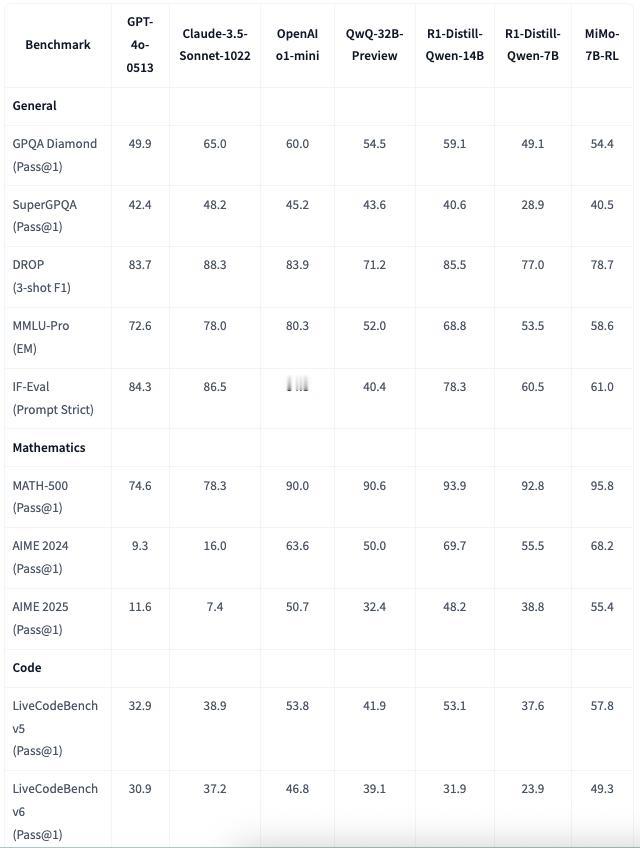

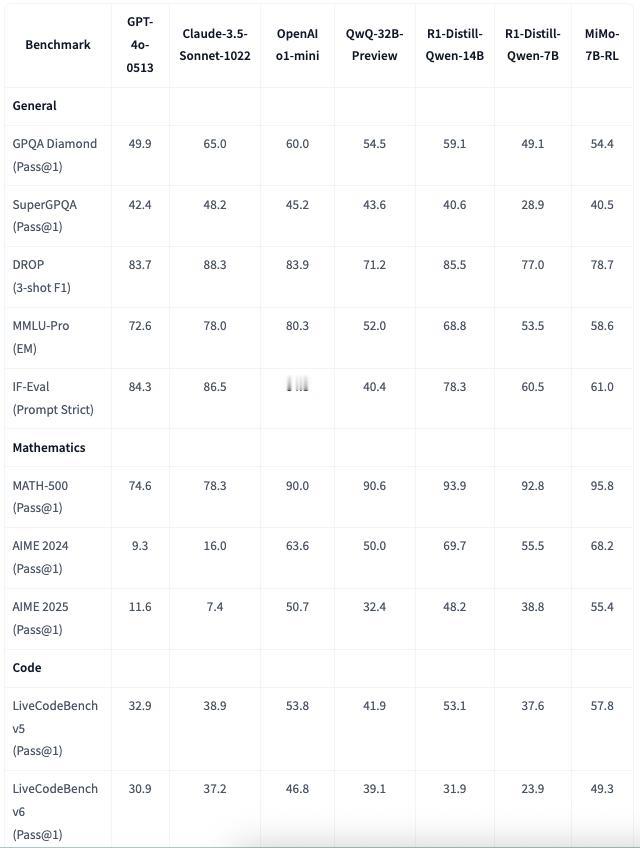

小米悄悄在HuggingFace开源了一组7B参数大小的模型,包括了Base、SFT和RL和RL-Zero四个版本。 模型训练过程和最近的这些推理模型类似,预训练使用了25T规模数据(对于7B大小来说不少了),然后再做SFT和RL。 从基础benchmark来看MiMo-7B-RL领先QwQ-32B-Preview,略低于o1-mini,也已经很强了。7B的大小也很符合小米在LLM上的定位——围绕核心手机业务,7B的FP8只需要7GB左右内存、Int4只需要4GB,很适合端侧部署。

小米悄悄在HuggingFace开源了一组7B参数大小的模型,包括了Base、SFT和RL和RL-Zero四个版本。 模型训练过程和最近的这些推理模型类似,预训练使用了25T规模数据(对于7B大小来说不少了),然后再做SFT和RL。 从基础benchmark来看MiMo-7B-RL领先QwQ-32B-Preview,略低于o1-mini,也已经很强了。7B的大小也很符合小米在LLM上的定位——围绕核心手机业务,7B的FP8只需要7GB左右内存、Int4只需要4GB,很适合端侧部署。

猜你喜欢

【117评论】【15点赞】

【206评论】【26点赞】

【5评论】【1点赞】

【174评论】【36点赞】

【196评论】【23点赞】

【70评论】【4点赞】

作者最新文章

热门分类

房产TOP

房产最新文章