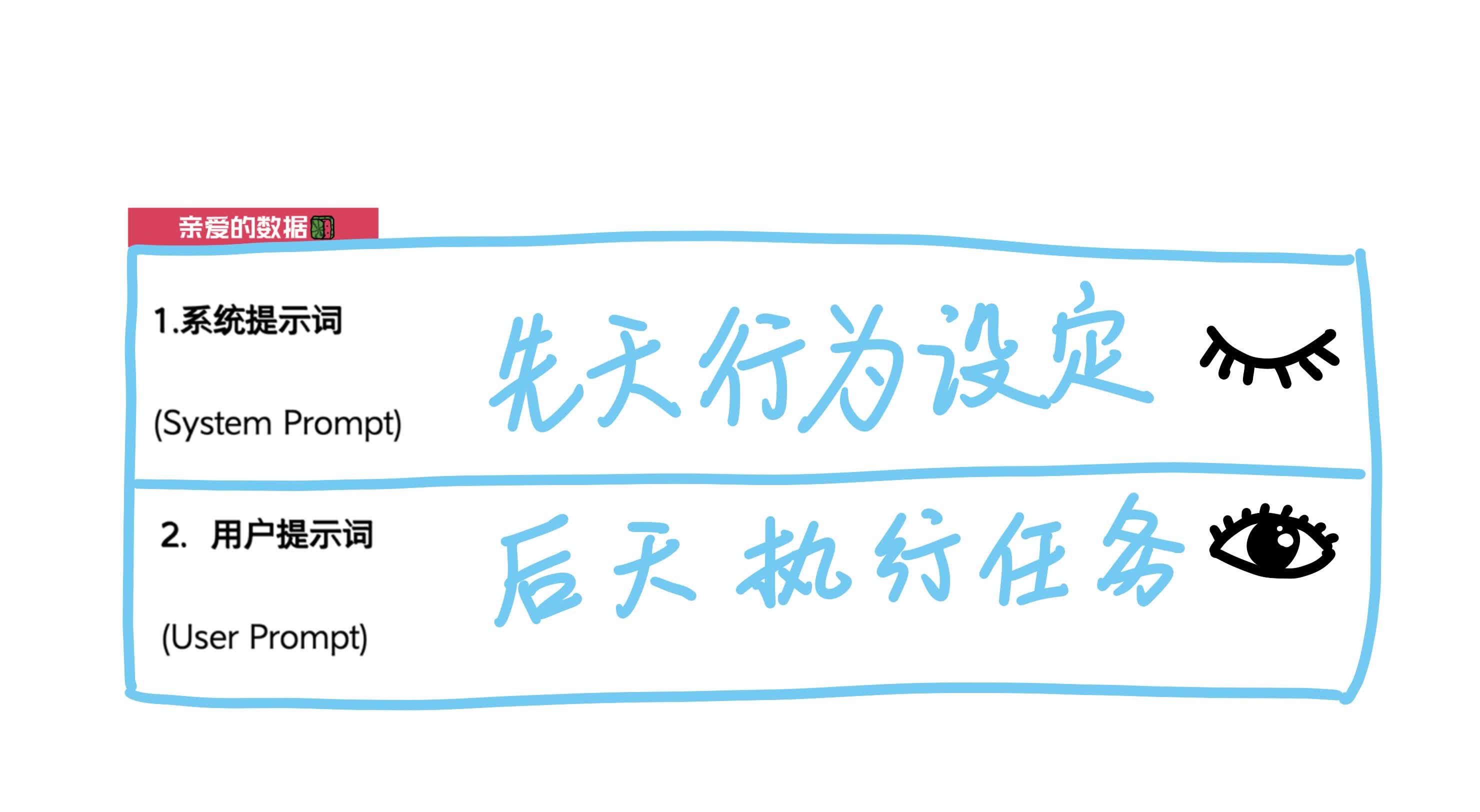

为什么说系统提示词是大模型调用的最前端? 从用户发起到模型给出最终回答的完整“调用链”流程: 1用户输入 你在聊天框里输入一句话,比如“帮我写一段产品介绍”。 2前端收集上下文 聊天界面会把三部分内容拼到一起: 2.1系统提示词(System Prompt):隐藏在最前面定义模型先天行为规则 2.2历史对话(Assistant + User Prompts):之前交互的来回内容 2.3当前用户提示词(User Prompt), 你刚才输入的新问题 3拼成完整 Prompt 这三部分合成一个大文本(通常很长), 送到模型的 API。 4模型内部处理 4.1Tokenization:把文本拆成一个个 token 4.2Encoding:把 token 转成向量 4.3多层网络计算,结合所有输入信息 4.4根据参数和提示,预测下一个最可能的 token 5工具调用(可选) 如果提示词里要求调用外部工具(如检索、计算),模型会先输出一个“函数调用说明”(Function Call),由后端或 MCP 服务器执行该工具,拿到结果后再继续生成。 6整合输出 模型把生成的文本、可能的函数调用结果都拼接成一条完整响应,再返回给前端。 7聊天界面把模型返回的文本显示给你,如果有工具结果,也会一并呈现。 8循环迭代 下一轮你继续提问时,上述完整响应又会被加入“历史对话”中,成为下次 Prompt 的一部分。整个链路的最前端,就是那段系统提示词,它在任何用户输入前就先被加载,确保模型从“最底层”就遵守既定规则。 用户看不到这段提示词,却受它严格约束; 同时,又能在后续“后天”加入新的用户提示,让模型输出具体内容。