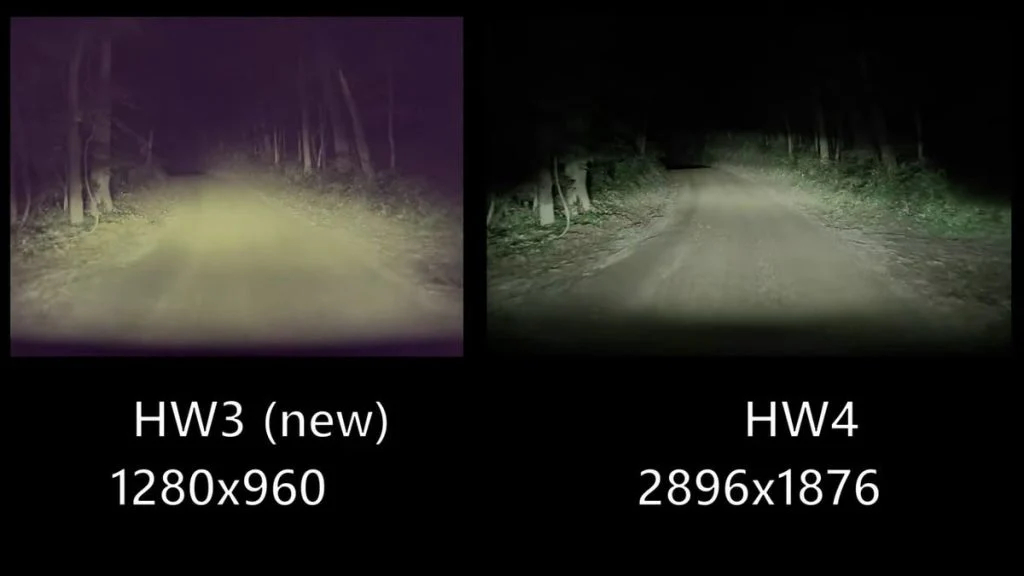

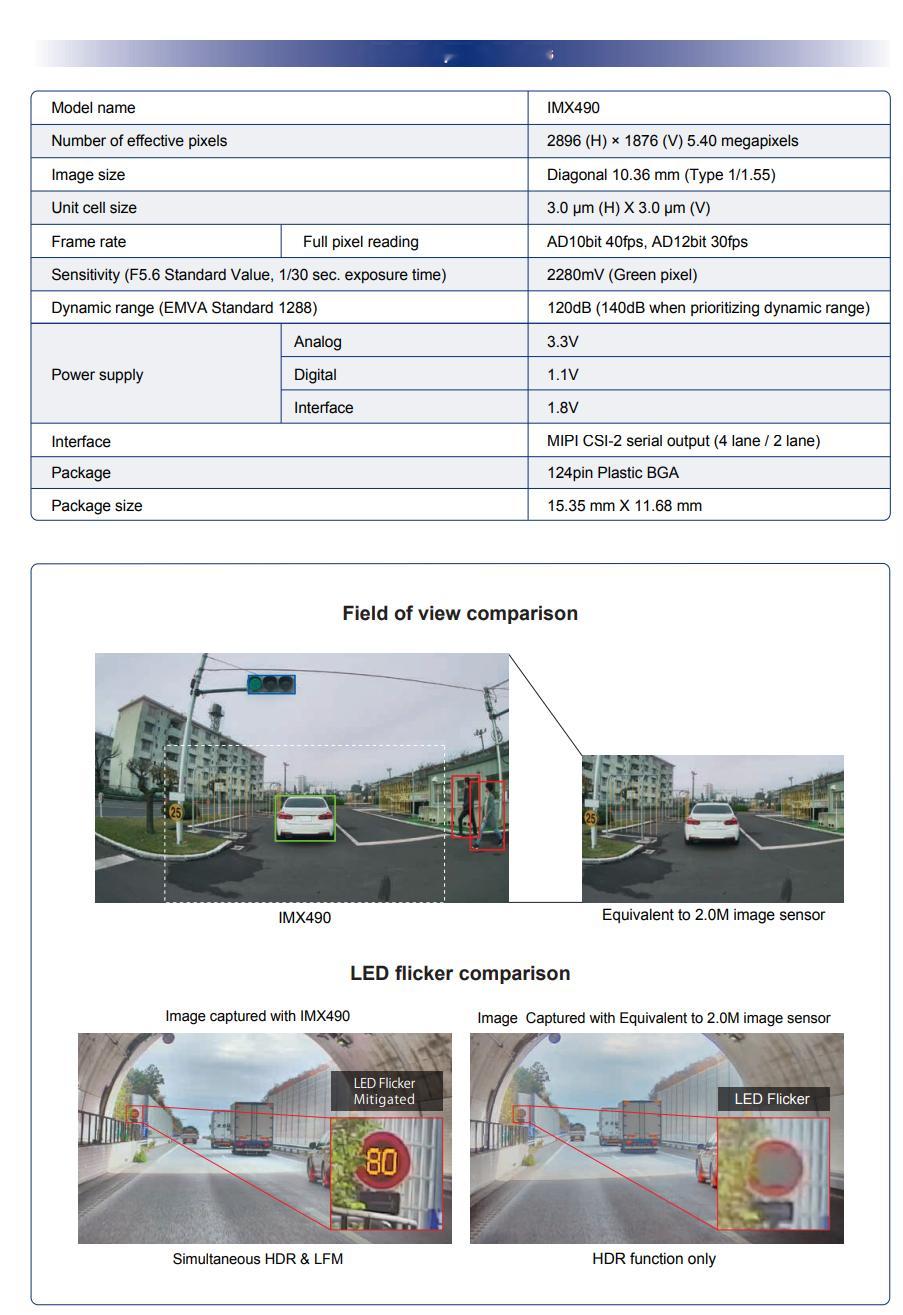

看到康总发的马斯克说纯视觉安全性的部分,直觉告诉我不对劲,老马估计又在瞎吹,Tesla 最新的 HW4(AI4)还是用的 IMX490, 一个标准的车规级 CMOS(图3/图4), 所以根本不可能实现直接光子计数(direct photon count)。

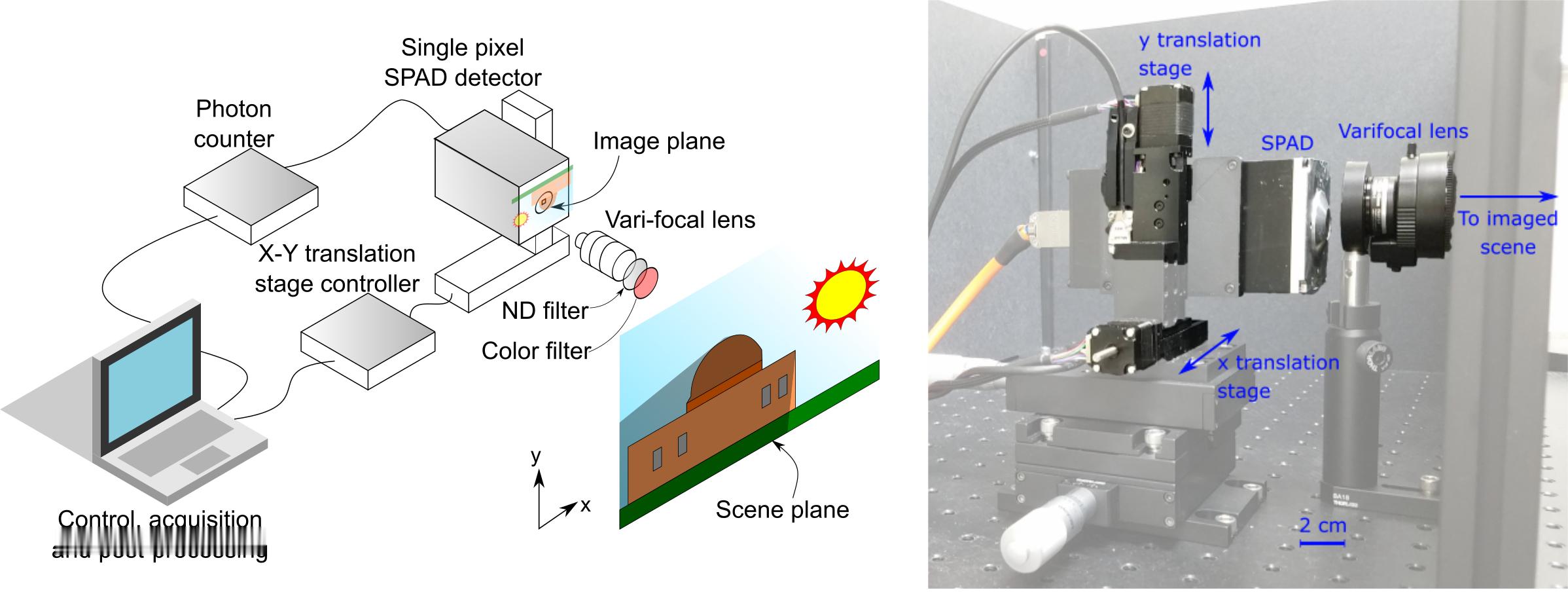

直接光子计数(direct photon count)需要专用的硬件,比如说单光子雪崩二极管(SPAD)才可以实现,也就是图5和图6的东西,它们是可以直接测量光子数量,而不是像 CMOS 一样,通过积累电荷转换为电压。

在这个部分,马斯克 100% 就是纯瞎吹。

后面的去掉 ISP 的部分有没有道理呢?

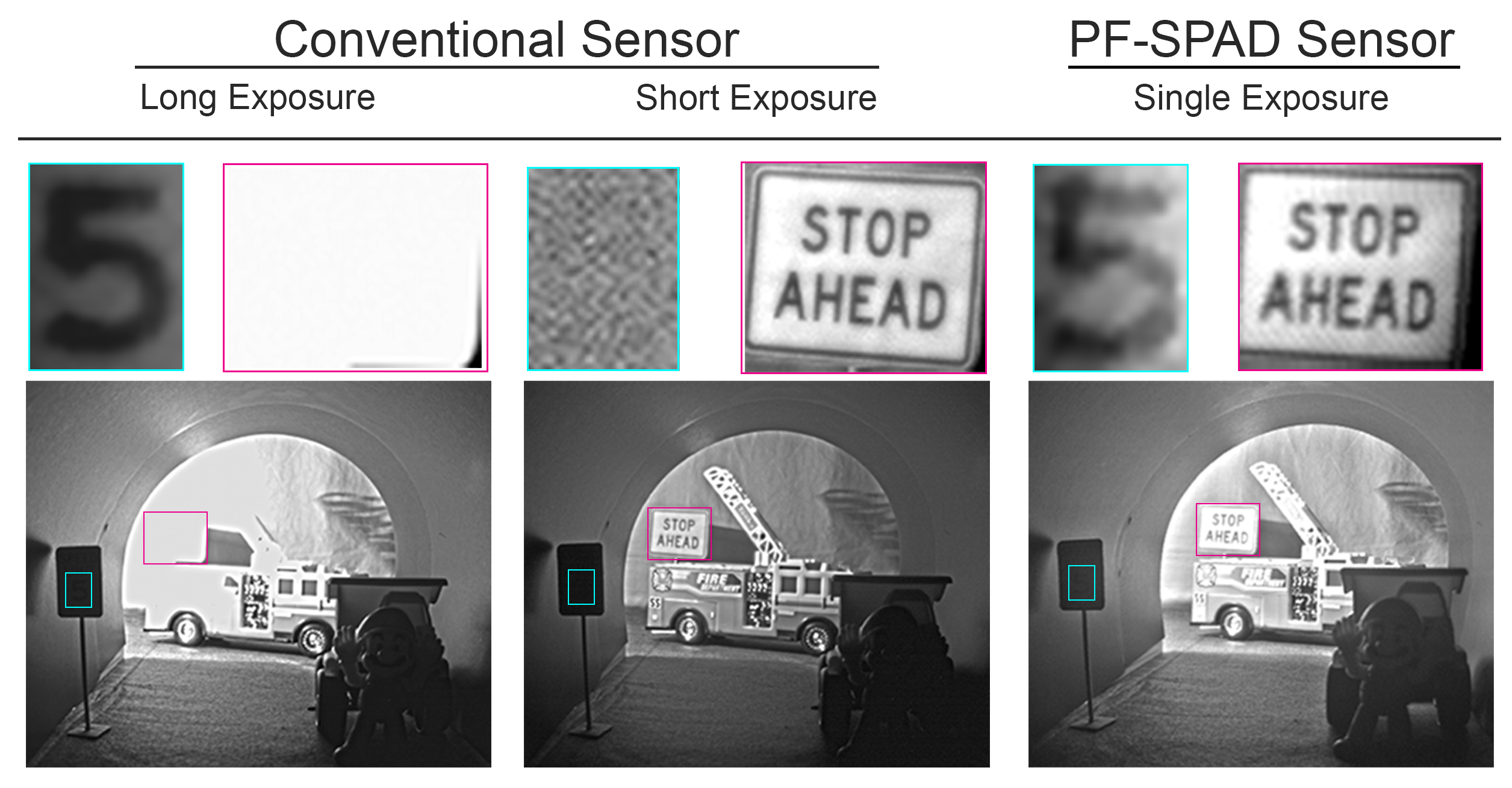

去掉 ISP 确实可以进行更原始的处理,输出位深当然也可以增加,但是遇到了超过 CMOS 动态范围的场景,不管你在 YUV 还是 RGB 环节,都是看不到任何东西的,所以并不能「大幅提升动态范围」,只能说减少一个环节确实可以降低处理延时。

而现在 Tesla 用的 IMX490, 它的单次曝光动态范围就是 120db, 多帧合成模式能扩展到 140db, 这个数字确实是比普通相机 CMOS 的动态范围要高很多的,跟人已经差距不大了。

但是跟人眼差距不大,就可以吗?

做辅助驾驶是可以的,因为控制权在人手里。

如果要做自动驾驶,我是不信任只有视觉的产品。

因为人也经常要被眩光晃到看不清。