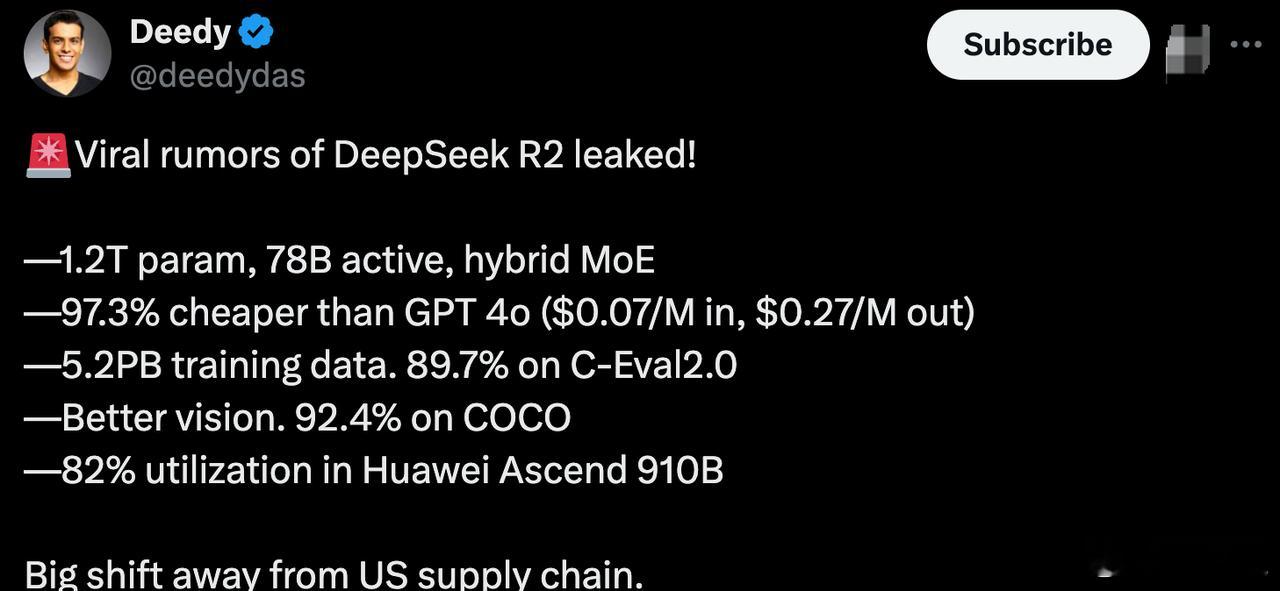

DeepSeekR2最新爆料DeepSeekR2成本下降97.3%

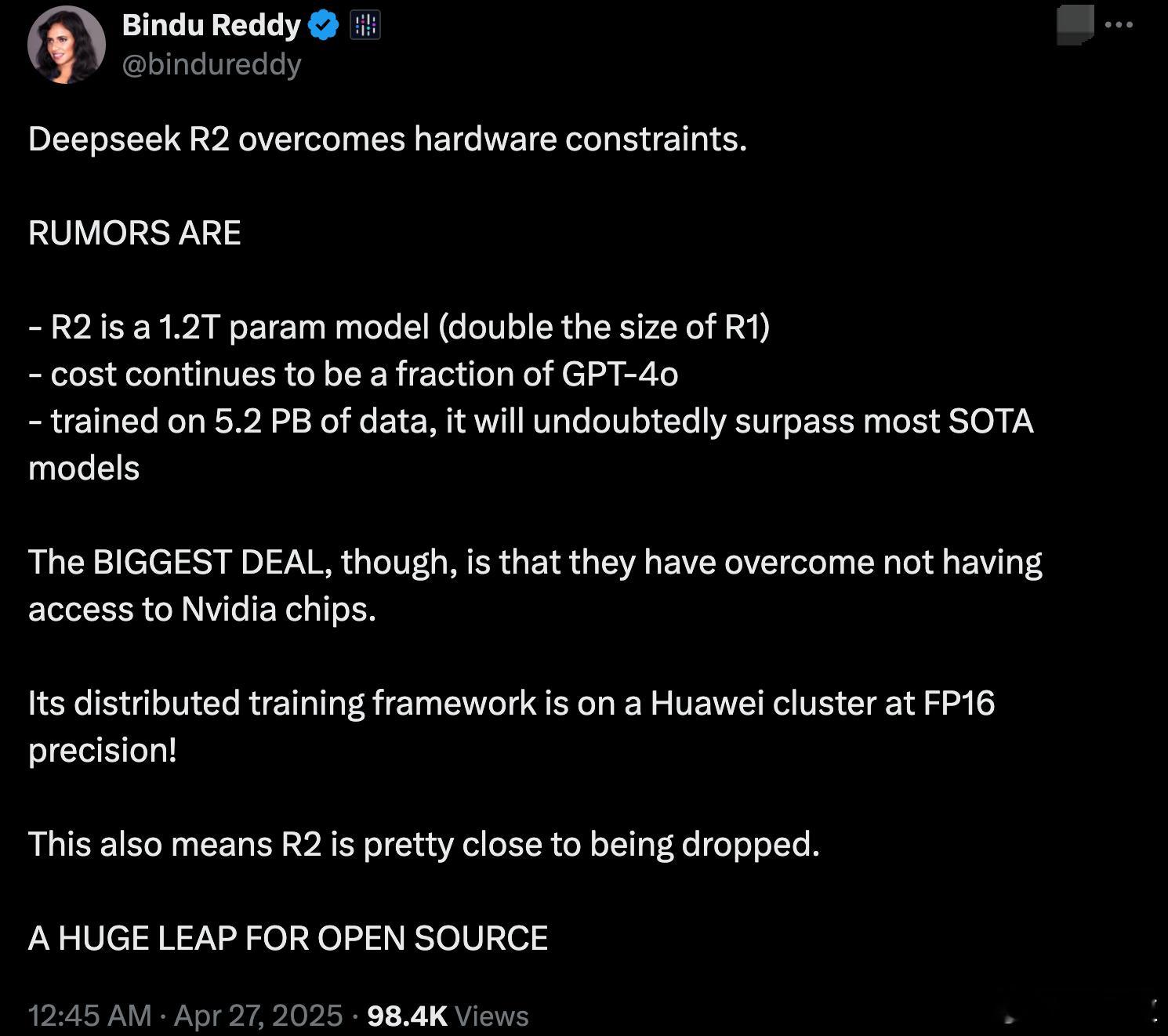

DeepSeek R2最新爆料来了,单位成本居然下降97.3%,而且彻底摆脱了对英伟达芯片的依赖!

- 单位成本暴降97.3%:训练和推理的单位成本,比GPT-4o下降了惊人的97.3%。具体来看,传言是输入每百万tokens只要0.07美元,输出是0.27美元。这意味着,用同样的钱,别人训练一次模型,DeepSeek能训练30次以上。

-参数量和训练数据:R2模型参数量达1.2万亿,是R1的两倍。其中活跃参数为78亿,走的是混合专家模型(MoE)路线。另外,R2的训练数据量达5.2PB,覆盖范围极广。

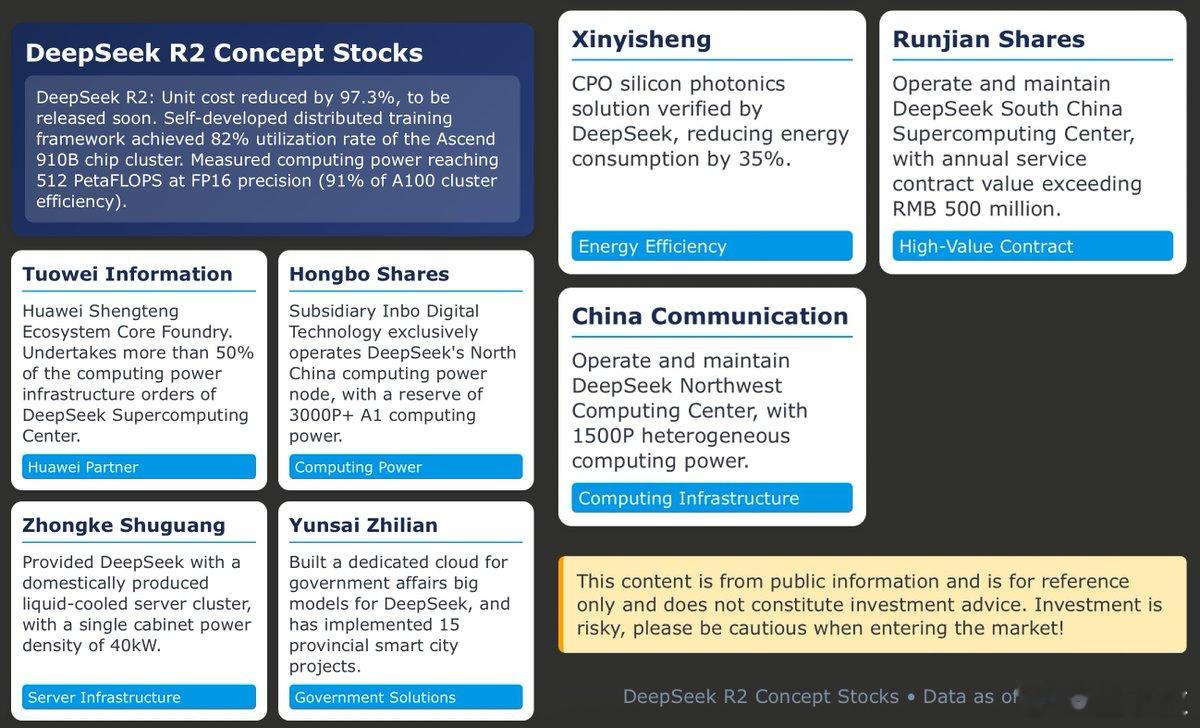

- 摆脱英伟达芯片:DeepSeek R2整个训练完全没用英伟达显卡,而是全部基于华为的Ascend 910B集群。团队自主搭建了分布式训练框架,在浮点16位(FP16)精度下,实测集群算力达到512 PetaFLOPS,集群利用率高达82%,整体性能约为英伟达A100集群的91%。

- 性能方面:在最新的C-Eval 2.0评测中,R2取得了89.7%的得分,在COCO图像测试中则实现了92.4%的准确率,展现出强大的综合性能。

- 量化压缩技术:DeepSeek R2在8bit精度下,模型体积压缩了83%,而精度损失不到2%,大幅提升了端侧部署的可行性。

值得注意的是,目前上述信息还没有获得内部人士证实,请大家理性围观。

如果上述消息属实,DeepSeek R2在开源社区上线之日,很可能会引发资本市场的又一轮震动。DeepSeekR2

![DeepSeekR2都有哪些爆料懂了!马上做空英伟达![doge]](http://image.uczzd.cn/16907771309772631714.jpg?id=0)

木木城域

期待使用,deepseek太牛了👍👍👍

SvvvS

这年头不吹牛逼,玩不下去

东方 回复 04-28 00:11

你美爹都服了,你不服?